Forte de son expérience d’analyse de texte, l’entreprise OrphAnalytics a développé un outil sans équivalent de détection de textes ChatGPT : cet outil multilingue exploite le cahier des charges de ChatGPT pour détecter la production automatique de textes, sans besoin de connaître les modèles de lang...

QAnon a publié de nouveaux messages en juin 2022 après une interruption de près de deux ans. Grâce à sa technologie linguistique computationnelle, l'entreprise OrphAnalytics peut attribuer ces messages à son principal suspect, Ron Watkins.

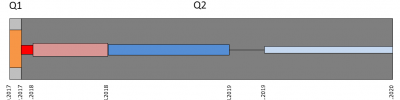

D'octobre 2017 à décembre 2020, QAnon a posté des centaine...

Deux études linguistiques indépendantes identifient Paul Furber et Ron Watkins comme les probables auteurs

Qui est la personne qui se cache derrière les messages de QAnon ? Plusieurs enquêtes d'actualité ont déjà présélectionné une douzaine d'auteurs potentiels. Aujourd'hui, la linguistique inform...

Fin 2020, notre communiqué de presse annonçait que les analyses stylométriques avaient repéré deux styles (probablement deux auteurs) dans l’ensemble des messages terroristes QAnon.

Les deux styles repérés contredisent la croyance partagée par les sympathisants du mouvement complotiste qu’une seul...

« OrphAnalytics aurait produit une expertise stylométrique dans un cas judiciaire non résolu depuis 1984? Par principe, l’entreprise ne communique jamais sur ses travaux d’expertise.

Le procureur général Thierry Pocquet du Haut-Jussé confirmait hier aux médias la réception de cette expertise. Aujo...